|

DeepSeek全球下载榜单登顶,流量巨大。春节这段时间,DeepSeek这把火真的是太猛了,几乎烧遍了全球。翻开朋友圈,打开视频号,清一色的关于DeepSeek的各种消息。这泼天的流量丝毫不亚于当初OpenAI爆火的时候。因为太过火爆了,导致DeepSeek这段时间用的时候几乎天天崩溃。经常出现“服务器繁忙,请稍后再试”的情况,这里为大家带来DeepSeek R1本地部署的方法,支持WebUI离线使用,感兴趣的朋友欢迎前来查看。 先下载所需工具:

DeepSeek R1 本地部署版本(国产人工智能 AI ) + web-ui 可以断网 类型:办公软件 大小:937MB 语言:简体中文 时间:2025-02-07 查看详情如果有去注册的朋友应该都知道这段时间新用户几乎都注册不了,如果发现能注册,建议大家赶紧去注册体验一下。 DeepSeek官网:https://www.deepseek.com/

这是我在昨天使用deepseek的情况,时不时就会遇到下面这个回复。

用着用着就崩了,很是尴尬。 后面才发现DeepSeek居然是开源的, 那既然DeepSeek R1是开源的,那就直接本地部署使用吧。 这样也就省去了诸多麻烦。 好了,先给大家做个简单的科普。 什么是DeepSeek R1?DeepSeek-R1是杭州深度求索人工智能基础技术研究有限公司发布的高性能AI推理模型,对标OpenAI的o1正式版。 模型通过大规模强化学习技术进行后训练,仅需极少量标注数据, 便能在数学、代码和自然语言推理等任务上取得卓越表现。 DeepSeek-R1遵循MIT License开源,支持模型蒸馏,训练其他模型。 据说DeepSeek-R1的训练成本居然还不到OpenAI的1/50, 这个真的是太牛了!!! 大写的牛!!!! 各项性能指标更是和OpenAI-o1 模型不相上下,甚至做到了小部分的超越,关键是开源的,我们可以本地部署使用

这里我们来介绍如何用Ollama + Open-WebUI来一键部署DeepSeek R1。 这俩好搭档非常之牛掰且好用,看他俩在Github的Star就知道了。

用Ollama管理、运行Deepseek,在Open-WebUI接入Ollama之后, 我们就可以完全界面化去下载安装Deepseek R1, 界面化给大模型调整参数,并设定预设prompt,以及对话(如下图), 非常方便。

好了,废话不多说,我们开始本地部署Deepseek R1! 先安装Ollama和Open-WebUI 安装 Ollama下载 Ollama(官网较慢,可以使用本站提供的地址)

DeepSeek R1 本地部署版本(国产人工智能 AI ) + web-ui 可以断网 类型:办公软件 大小:937MB 语言:简体中文 时间:2025-02-07 查看详情

Ollama(本地LLM管理/WebUI对话) for Windows v0.5.7 安装免费版 类型:编程工具 大小:740MB 语言:简体中文 时间:2025-02-07 查看详情访问 Ollama官网(https://ollama.com/),根据操作系统(Windows、macOS 或 Linux)下载安装包。 对于 Windows 用户,下载 OllamaSetup.exe 并双击安装。

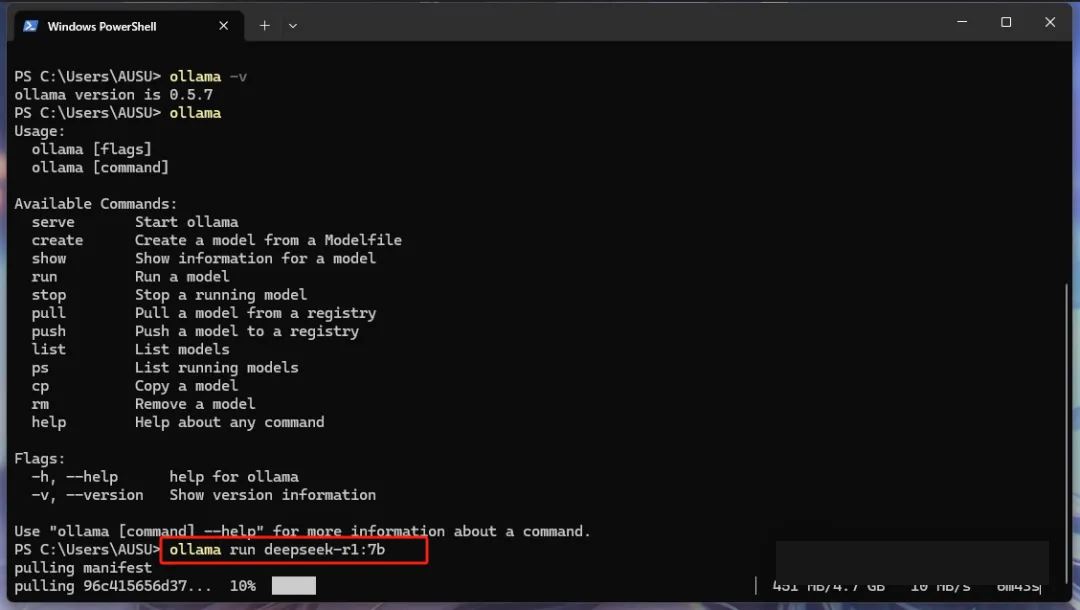

这里需要注意,它跟我们平常普通的软件安装不一样,这里安装完成后,桌面基本上是没有任何图标的, 但是我们可以通过命令行工具去验证是否安装成功。 打开命令行工具,输入以下命令验证是否安装成功: ollama --version 如果显示版本号,说明安装成功。

Ollama已经在第一时间支持DeepSeek-R1, 模型地址:deepseek-r1 。 根据自己的显存选择对应的模型,2G显卡只能选1.5b的。 硬件需求所以对于大多数个人用户,建议部署4bit量化模型: 7B/8B模型:8GB显存。 14B模型:16GB显存。 32B模型:22GB显存。 70B模型:48GB显存。 下图是ollama官方给出的模型选择建议

Ctrl + Shift + Esc打开任务管理器->性能->GPU

如何运行deepseek? 运行模型很简单,确定好想要的模型后,复制对应的命令到你的终端并执行。 使用以下命令下载 DeepSeek-R1 模型: DeepSeek-R1-Distill-Qwen-1.5B ollama run deepseek-r1:1.5b DeepSeek-R1-Distill-Qwen-7B ollama run deepseek-r1:7b DeepSeek-R1-Distill-Llama-8B ollama run deepseek-r1:8b DeepSeek-R1-Distill-Qwen-14B ollama run deepseek-r1:14b DeepSeek-R1-Distill-Qwen-32B ollama run deepseek-r1:32b DeepSeek-R1-Distill-Llama-70B ollama run deepseek-r1:70b 该命令会自动下载并加载模型,下载时间取决于网络速度和模型大小。

下载完成后,可以使用以下命令查看模型信息: ollama list 该命令会列出本地已下载的模型及其状态。这是我笔记本上的本地模型。

使用以下命令启动 DeepSeek-R1 模型: ollama run deepseek-r1:1.5b 启动后,模型会进入交互模式,用户可以直接输入问题并获取回答。 测试功能在交互模式下,可以测试 DeepSeek-R1 的多种功能,例如: - 智能客服:输入客户常见问题,如“如何安装软件?”。 这是测试的效果

只要是支持Ollama的webUI都可以,如Dify,AnythingLLM都可以。 Open WebUI也强烈推荐大家安装使用,它应该是目前功能最全,最好用的大模型WebUI工具。 安装完Ollama和Open WebUI,并在Open WebUI接入本地Ollama之后,就可以非常方便的一键安装DeepSeek R1使用了~ 如何安装Open WebUI可视化交互界面工具目前我知道的大概有几种方式: 1、使用Docker-desktop,不仅是open-webui,其他绝大多数Github的开源项目都支持用docker一键部署,docker的好处是自带虚拟环境,不需要在本地额外安装一堆其他环境、依赖等,是管理、部署项目的神器。 2、自行安装Python环境,使用Pip的方式安装即可 ☆ 次推荐 3、不需要安装Docker-desktop,也不需要安装Python环境,直接使用浏览器Web UI插件就能搞定(下面下载链接与教程就是,大家可以点击查看)

DeepSeek-R1 本地部署联网Page Assist v1.5.10 本地AI模型web ui 开源版 类型:生产工具 大小:22.5MB 语言:简体中文 时间:2025-04-21 查看详情本地部署DeepSeek-R1联网 超简单的DeepSeek离线部署联网搜索教程 ☆ 首要推荐 4、还可以使用ChatBox、Cherry Studio等桌面客户端都可以(下面也给大家提供了教程,点击查看) DeepSeek服务器繁忙怎么解决?CherryStudio&DeepSeek 告别不响应 这里我们先采用第二种方式(安装Python环境的方式),而且也是与Ollama结合比较紧密的Open WebUI为例: GitHub地址:https://github.com/open-webui/open-webui 如果本身已经安装有Python环境,如:Anaconda, 那么就直接Pip安装即可,至于如何安装Python环境和Anaconda环境,自行度娘即可,这里不做介绍。 安装open-webui服务pip install open-webui 启动open-webui服务open-webui serve 启动后,在浏览器中访问 :8080/ 即可进入 Open WebUI 界面。

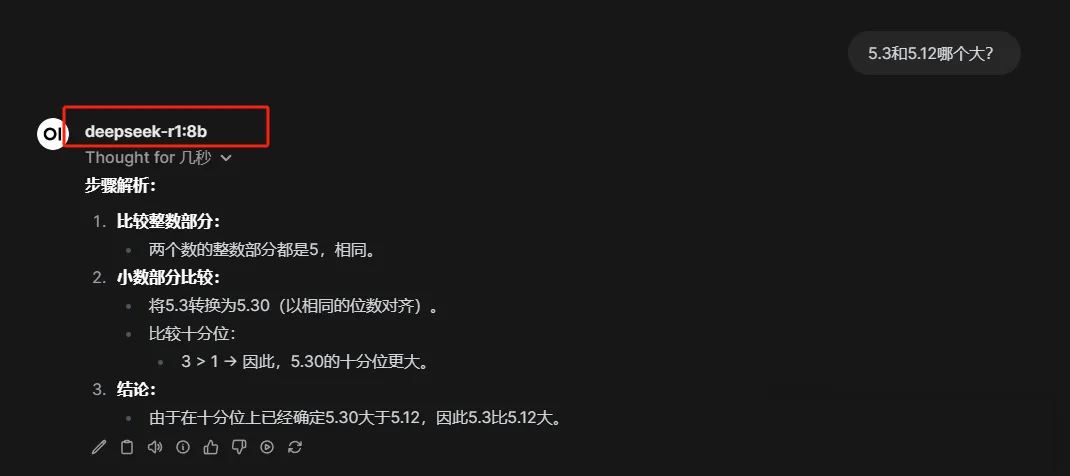

在 Open WebUI 界面中,选择已下载的 DeepSeek-R1 模型,即可开始对话测试。

大家可以看到,效果非常不错。 上面我分别使用了五种模型进行测试,只有R1模型确确实实是在推理,而其他两种默认的模型都是普通模型,没有推理能力。 注意事项硬件要求:DeepSeek-R1 对硬件有一定要求,建议使用支持 GPU 的设备以获得更好的性能。如果电脑配置一般建议选择1.5b就足够。 网络配置:如果下载速度较慢,可以使用国内镜像加速。 本地化支持:Open WebUI 支持中文界面,可以在设置中调整语言。

通过以上步骤,您可以快速在本地部署 DeepSeek-R1 模型,并通过 Ollama 和 Open WebUI 进行高效交互。 使用建议从小型模型开始测试 根据实际需求选择合适版本 注意监控系统资源使用情况 定期备份重要对话数据 DeepSeek R1能做什么?处理复杂提示 揭示问题背后的推理步骤 在聊天界面中呈现并测试代码 提供强大的推理能力

虽然DeepSeek提供免费的网页和移动应用版本, 但选择本地部署有以下几个重要优势: 1. 隐私保护 所有数据都保存在本地计算机 无需担心数据被收集或用于其他目的 完全掌控数据安全 2. 离线访问 无需依赖网络连接 适合旅行或网络不稳定的场景 随时随地可用 3. 未来保障 避免可能出现的使用限制 不受未来商业化影响 永久免费使用 4. 更大的灵活性 可以根据需求微调模型 支持与其他工具集成 允许构建自定义界面 (责任编辑:) |